Salut l’équipe 👋

L’IA Générative d’Image permet de créer des visuels en tout genre ouvrant des perspectives autant pour les entreprises que pour l’art digital. Dans ce troisième article de la série IA Générative, nous explorerons son fonctionnement, son application en entreprise, et les implications juridiques qui l’entourent.

Let’s rewind

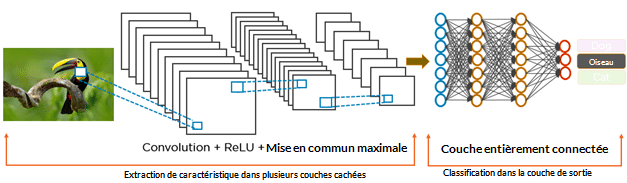

L’histoire des outils de génération d’images remonte aux débuts des réseaux neuronaux, en particulier avec les Réseaux Neuronaux Convolutifs (CNN) dans les années 80 et 90 (Yann LeCun). Ces réseaux ont marqué une avancée significative dans la capacité des machines à extraire des caractéristiques complexes à partir d’images.

Cependant, c’est en 2014 que la révolution a véritablement commencé avec l’introduction des Réseaux Génératifs Antagonistes (GAN)(Ian Goodfellow). Les GAN ont transformé le paysage de la génération d’images en instaurant un jeu adversatif entre un générateur et un discriminateur. Le modèle générateur a pour but de capturer la distribution des données d’entrée et générer de nouveaux échantillons appartenant au même domaine, alors que le discriminateur a pour but d’estimer les probabilités que des images soient issues de l’ensemble d’entraînement ou bien qu’elles aient été générées par le générateur.

Cette approche a permis de créer des œuvres d’art, de générer des visages de personnes fictives avec un grand réalisme, et d’améliorer la résolution d’images.

Aujourd’hui l’IA générative d’images utilise des algorithmes pour créer des visuels à partir de descriptions textuelles ou de données d’entrée spécifiques. Des outils comme DALL-E et Midjourney illustrent la capacité de ces technologies à transformer des mots en images éloquentes, offrant ainsi un potentiel créatif quasi illimité.

Comment ça marche?

Les modèles texte-image comportent deux composants clés : un réseau neuronal formé pour associer une image avec un texte qui décrit cette image, et un autre réseau formé pour générer des images à partir de zéro. L’idée de base est d’amener le deuxième réseau neuronal à générer une image pour que le premier réseau neuronal accepte comme correspondance avec l’invite.

La grande avancée derrière les nouveaux modèles réside dans la manière dont les images sont générées. La première version de DALL-E utilisait une extension de la technologie derrière le modèle de langage GPT-3 d’OpenAI, produisant des images en prédisant le pixel suivant d’une image comme s’il s’agissait de mots dans une phrase. Cela a fonctionné, mais pas bien.

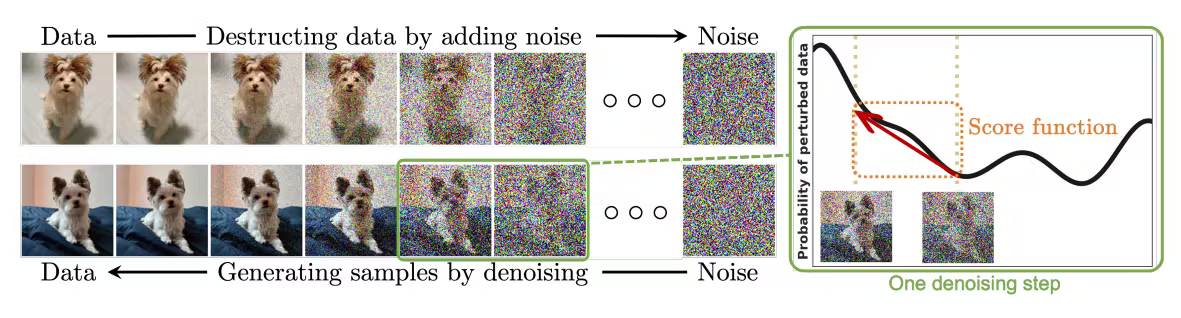

Au lieu de cela, DALL-E 2 utilise ce qu’on appelle un modèle de diffusion. Les modèles de diffusion sont une technique de génération d’images où un réseau de neurones est formé pour éliminer progressivement le bruit d’une image jusqu’à ce qu’elle devienne claire. Le processus commence par modifier aléatoirement les pixels d’une image initiale, étape par étape, jusqu’à ce qu’elle se transforme en un ensemble de pixels désordonnés, ressemblant à de la « neige » sur un écran de télévision sans signal. Le réseau neuronal est ensuite entraîné à inverser ce processus et à prédire à quoi ressemblerait la version la moins pixelisée d’une image donnée. Le résultat est que si vous donnez un désordre de pixels à un modèle de diffusion, il essaiera de générer quelque chose d’un peu plus propre. Rebranchez l’image nettoyée et le modèle produira quelque chose de plus propre encore. Faites cela suffisamment de fois et le modèle peut vous emmener de la neige télévisée à une image haute résolution.

Midjourney, d’autre part, a été développé par un laboratoire de recherche indépendant et a rapidement évolué, atteignant la version 5.2. Contrairement à DALL-E, Midjourney utilise un agglomérat de contenus web pour sa formation, exploitant des ensembles de données ouvertes de diverses sources en ligne sans demander de consentement explicite aux artistes ou auteurs des images. Son processus de génération d’images commence également par un champ de bruit visuel qu’il inverse progressivement pour révéler une image nette et affinée, ce qui est légèrement différent de la méthode de DALL-E 2.

Vous pouvez-ici comparer les images des différents modèles avec le même prompt. Lequel Préférez-vous ?

Test avec le prompt “A realistic photo of a young happy couple”

Dall E

Dall E 2

Dall E 3

Midjourney

Et les entreprises dans ce game ?

Les entreprises de divers secteurs exploitent aujourd’hui l’IA générative d’images pour leur communication interne, blog, posts de réseaux sociaux, prototypage etc.

Cependant, ces outils ne sont pas sans limites. L’IA générative ne gère pas toujours bien les concepts abstraits et peut s’appuyer sur des données d’entraînement génériques, ce qui pose des défis en termes de personnalisation et d’originalité.

👇 Le cas Adobe

En réponse à DALL-E and Midjourney, Adobe a développé Firefly pour produire des images, vidéos, retouches etc. Adobe a décidé de s’appuyer exclusivement sur les visuels présents sur Adobe Stock ainsi que sur d’autres contenus 100 % libres de droit, afin que ses utilisateurs puissent utiliser les images générées à des fins commerciales, sans craindre un quelconque problème de propriété intellectuelle. Enfin, la puissance de Firefly est que c’est directement intégré dans des applications comme Photoshop, Illustrator et Adobe Express, offrant des fonctionnalités telles que le remplissage génératif et l’expansion d’images, ainsi que la génération de graphiques vectoriels personnalisables.

En résumé, Firefly c’est 🤯🤯🤯

La question de la protection de l’image, des marques et créateurs

La réglementation de l’utilisation des outils d’IA de génération d’image dans l’Union Européenne sera principalement encadrée par le règlement sur l’intelligence artificielle (AI Act) approuvé le 2 février 2024.

Commençons par parler de la question des droits d’auteur, deux questions se pose, à qui appartient l’œuvre créée? et peut-on se servir d’une œuvre protégée lors de l’entrainement des modèles?

Le domaine juridique s’adapte pour répondre aux défis posés par l’IA générative d’images. Les lois actuelles sur le droit d’auteur ne reconnaissent pas les œuvres créées sans intervention humaine significative comme éligibles à la protection du droit d’auteur.

⚖️ En droit français, seule une personne physique peut avoir la qualité d’auteur.

Une machine ou un logiciel ne peut donc pas se voir reconnaître comme l’auteur d’une œuvre au sens du Code de la propriété intellectuelle. (La situation est différente au Royaume-Uni par exemple.) Ainsi, dans la mesure où l’utilisateur n’a pas la maîtrise des résultats qui seront générés par l’IA, il est difficile de considérer que ceux-ci sont empreints de sa personnalité. En revanche, si le résultat généré par IA est retravaillé par l’utilisateur, celui-ci peut être protégé par un droit d’auteur s’il répond à l’exigence d’originalité du Code de la propriété intellectuelle.

⚖️ Pour établir une violation des droits d’auteur afférents à une œuvre qui aurait contribué à nourrir une IA, il faut démontrer que le résultat généré grâce à l’IA reproduit en intégralité ou au moins en partie les caractéristiques originales de cette œuvre. Or, cela ne sera pas le cas dans la majeure partie des cas.

Pour répondre à cette problématique L’IA Act prévoit notamment d’imposer aux plateformes d’IA spécifiquement destinées à générer du contenu tel que du texte complexe, des images, du son et des vidéos, à communiquer au public un « résumé suffisamment détaillé » de l’utilisation des données d’entraînement protégées par le droit d’auteur. Cette disposition (article 28b, 4. c) du projet) semble imposer aux IA de citer leurs sources, reste à voir si cela est faisable en pratique.

✍🏼 Pour une entreprise qui utilise sa propre IA, le premier réflexe à adopter est de sélectionner les données/images qui sont utilisées pour nourrir l’IA et s’assurer que l’auteur de celles-ci ne s’est pas opposé à leur reproduction/extraction aux fins de la fouille des textes et de données. Pour une entreprise qui utilise des IA développées par des tiers comme OpenAI, il est important de prendre connaissance des conditions générales d’utilisation de ces plateformes, et notamment des dispositions relatives à la titularité des droits de propriété intellectuelle sur les contenus générés et sur la responsabilité de la plateforme, ainsi que les éventuelles licences octroyées à la plateforme pour la réutilisation des œuvres générées pour nourrir l’IA au bénéfice d’autres utilisateurs.

Le troisième point où la loi prévoit des restrictions, est par rapport aux faux contenus et à l’utilisation d’image de personne publique.

En France, certains mécanismes juridiques peuvent déjà être utilisés par un individu souhaitant empêcher et réprimer le détournement de son image sans son autorisation. Ainsi en est-il, sur le plan civil, de l’article 9 du Code civil, qui consacre le droit à la vie privée. Sur ce fondement les personnes apparaissant sur des Deepfakes pourraient invoquer une atteinte à leur image.

Sur le plan pénal, la reprise des attributs de la personnalité d’une personne sans son consentement est susceptible**, sous certaines conditions, de constituer l’infraction d’atteinte** volontaire à la vie privée d’autrui au sens de l’article 226-1 du Code pénal.

Toutefois, dans l’objectif de créer un environnement numérique plus respectueux des droits et de la dignité de chaque individu et de lutter contre le phénomène de désinformation, l’état souhaite renforcer les mécanismes existants, pour y inclure expressément les Deepfakes (l’affaire Taylor Swift est le cas plus récent à ampleur global).

Un projet de loi visant à sécuriser et réguler l’espace numérique (projet de loi SREN) a introduit des amendements spécifiques pour lutter contre ces Deepfakes. Ce projet de loi a été adopté par les députés le 17 octobre 2023 lors de sa première lecture.

- Le premier amendement punit le fait de diffuser un contenu sur une personne généré par une intelligence artificielle (IA) sans son consentement, et sans mentionner qu’il s’agit d’un faux.

- Le second amendement créé un nouveau délit de publication d’hypertrucage (deepfake) à caractère sexuel, c’est-à-dire la diffusion de vidéos pornographiques créées par l’IA et représentant une personne sans son consentement.

La fin en quelques mots

Le 22 février 2024, Google à retiré de Gemini sa fonctionnalité de génération d’images, après d’importantes imprécisions, biais et problèmes d’inclusivité. La route est longue pour trouver un équilibre entre créativité, droit d’auteurs et droit à l’image. Ces dans de telles problématiques qu’être humain avec un sens éthique, à une valeur très importante dans le business.

J’espère que vous avez appréciés (long article) et à très vite team!

La gestion des données vous intéresse et vous êtes un professionnel ? Renseignez-vous sur mon programme de formation DARE – Data Manager: une formation de 2 jours pour acquérir les fondamentaux de la gestion des données et construire la stratégie MDM associée 🔥.

Have fun!

Laura