Salut a tous 👋,

Le « Artificial Intelligence Act », initié en 2021, a été approuvé ce vendredi 2 février 2024 par les pays membres de l’Union européenne, avant son renvoi devant le Parlement européen.

Le texte vise à assurer que les SIA (Systèmes d’Intelligence Artificielle) soient sûrs, respectent les droits fondamentaux et adhèrent aux valeurs européennes. C’est à dire, réguler le développement et l’utilisation d’IA pour un usage responsable et éthique.

Cela commence par la définition des acteurs et de leurs rôles

L’EU AI Act divise les acteurs impliqués dans l’IA en sept catégories selon leur rôle :

- Fournisseurs : Ceux qui conçoivent, développent ou mettent sur le marché des services d’IA. Ils doivent s’assurer que leur système respecte les exigences de documentation technique, d’évaluation des performances et de consommation d’énergie.

- Importateur : L’importateur est celui qui introduit des systèmes d’IA provenant de pays tiers sur le marché de l’UE. Il doit veiller à ce que les produits importés soient conformes aux normes européennes.

- Distributeur : Cette catégorie inclut les entités qui mettent à disposition des systèmes d’IA sur le marché, sans être impliquées dans leur fabrication ou importation. Les distributeurs doivent s’assurer que les systèmes d’IA qu’ils distribuent respectent les réglementations en vigueur.

- Utilisateur (Déployeur): Les utilisateurs ou déployeurs sont les entités qui utilisent les systèmes d’IA dans leurs opérations quotidiennes. Ils doivent s’assurer que l’utilisation des systèmes est conforme aux exigences légales, en particulier pour les systèmes à risque élevé.

- Opérateur: Les opérateurs sont ceux qui gèrent le fonctionnement quotidien des systèmes d’IA, pouvant être différents des utilisateurs finaux. Ils ont la responsabilité de maintenir la conformité opérationnelle des systèmes d’IA.

- Fabricant : Il s’agit de l’entité qui produit physiquement les composants ou systèmes d’IA. Les fabricants doivent garantir que leurs produits sont fabriqués selon les standards de sécurité et de qualité requis.

- Personne affectée : Ce terme désigne toute personne qui est affectée par un système d’IA, par exemple, les individus soumis à une analyse ou une décision prise par un système d’IA. Bien qu’ils n’aient pas de responsabilités directes en matière de réglementation, la législation vise à protéger leurs droits fondamentaux.

Une entité peut changer de catégorie (par exemple, de déployeur à fournisseur) si elle modifie substantiellement un système d’IA ou le commercialise sous sa marque.

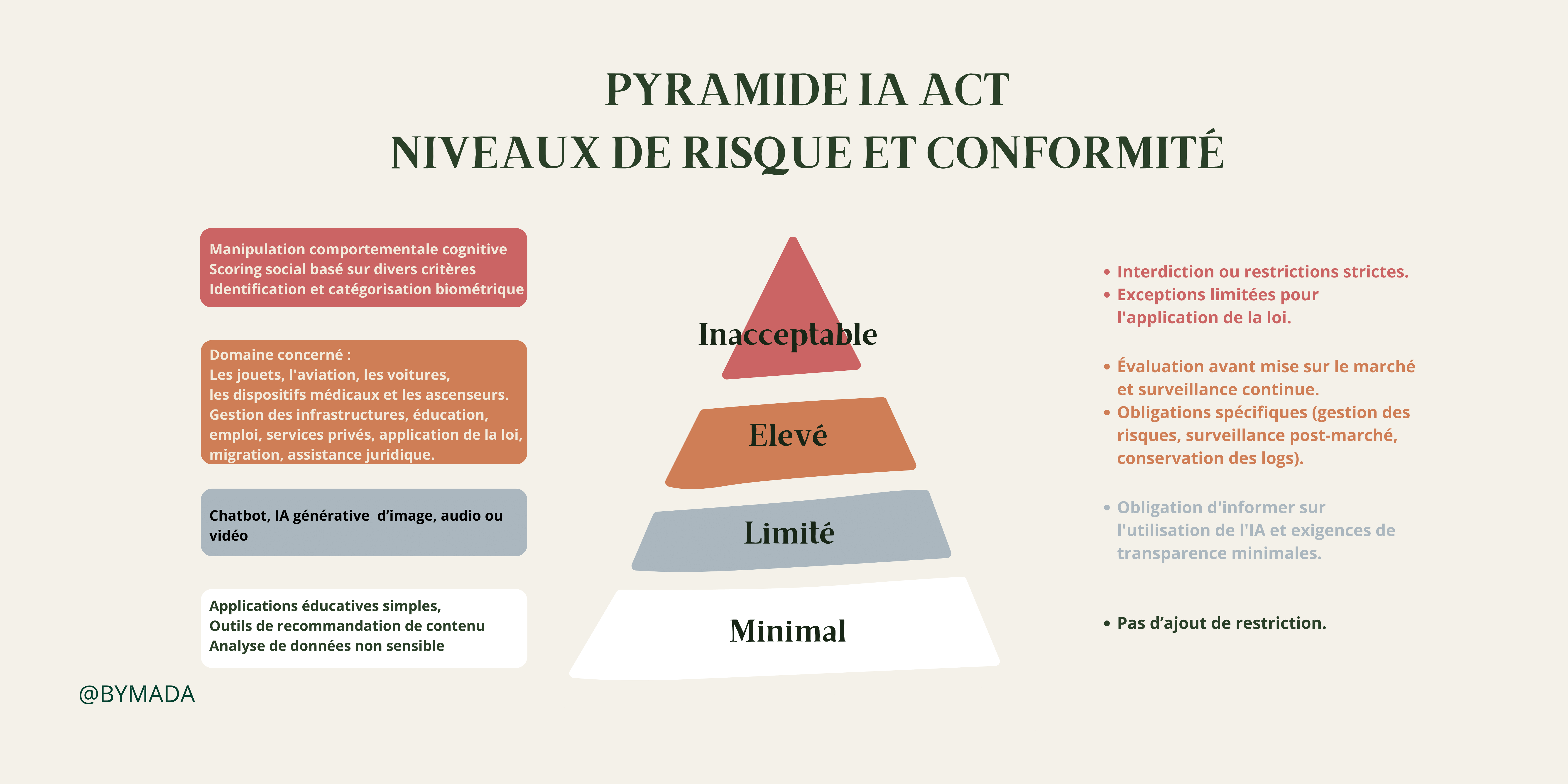

L’introduction de la catégorisation d’IA basée sur les risques

L’EU AI Act propose une classification des systèmes d’IA basée sur le niveau de risque qu’ils représentent pour la société. Cette approche vise à équilibrer l’innovation technologique avec la protection des droits fondamentaux et la sécurité des citoyens.

⚫️ Risque inacceptable : Cette catégorie concerne les utilisations d’IA qui sont jugées incompatibles avec les valeurs de l’UE ou qui violent les droits fondamentaux des individus. Ces applications sont interdites ou strictement limitées.

Ils comprennent :

- La manipulation comportementale cognitive des personnes ou de groupes vulnérables spécifiques : par exemple, des jouets activés par la voix qui encouragent un comportement dangereux chez les enfants.

- Le scoring social : la classification des personnes basée sur le comportement, le statut socio-économique ou les caractéristiques personnelles.

- L’identification et la catégorisation biométrique des personnes.

- Les systèmes d’identification biométrique à distance et en temps réel, tels que la reconnaissance faciale.

Certaines exceptions peuvent être autorisées à des fins d’application de la loi.

🔴 Risque élevé (SIAHR): Les systèmes d’IA qui affectent négativement la sécurité ou les droits fondamentaux seront considérés à haut risque et seront divisés en deux catégories :

- Les systèmes d’IA utilisés dans des produits relevant de la législation de l’UE sur la sécurité des produits. Cela inclut les jouets, l’aviation, les voitures, les dispositifs médicaux et les ascenseurs.

- Les systèmes d’IA relevant de domaines spécifiques qui devront être enregistrés dans une base de données de l’UE :

- La gestion et l’opération des infrastructures critiques

- L’éducation et la formation professionnelle

- L’emploi, la gestion des travailleurs et l’accès à l’auto-emploi

- L’accès et la jouissance des services privés essentiels et des services et avantages publics

- L’application de la loi

- La gestion de la migration, de l’asile et du contrôle des frontières

- L’assistance dans l’interprétation et l’application de la loi.

Tous les systèmes d’IA à haut risque seront évalués avant leur mise sur le marché et tout au long de leur cycle de vie.

Bon à savoir

✍🏻 Pour les SIA à Haut Risque (SIAHR) : Des obligations s’appliquent, telles que la mise en place de systèmes de gestion des risques, la surveillance post-marché, et la conservation des enregistrements d’activité (logs), jusqu’à qu’ils soient conforme.

✍🏻 Pour les Utilisateurs de SIAHR : Ils doivent assurer une supervision humaine et réaliser une analyse d’impact sur les droits fondamentaux.

🟡 Risque limité : Cette catégorie s’applique aux systèmes d’IA qui nécessitent une certaine transparence dans leur utilisation mais présentent un risque moindre comparé aux catégories précédentes. Par exemple, un chatbot devrait être conçu de manière à ce que les utilisateurs sachent qu’ils interagissent avec une machine et non avec un humain. Bien que les exigences soient moins strictes, les développeurs doivent encore informer les utilisateurs de l’utilisation de l’IA.

🟢 Risque minimal : La majorité des applications d’IA tombent dans cette catégorie, où le risque pour les droits et libertés des citoyens est considéré comme négligeable. Ces applications peuvent être largement utilisées sans réglementations supplémentaires strictes. Il s’agit, par exemple, des systèmes de recommandation de films ou de musique. Bien que ces applications soient largement exemptes de contraintes réglementaires, les principes généraux de sécurité et de respect de la vie privée s’appliquent toujours.

✍🏻 L’IA générative, comme ChatGPT, devra se conformer aux exigences de transparence :

- Révéler que le contenu a été généré par l’IA.

- Concevoir le modèle pour empêcher qu’il génère du contenu illégal.

- Publier des résumés des données protégées par le droit d’auteur utilisées pour l’entraînement.

Les modèles d’IA à usage général à fort impact, susceptibles de présenter un risque systémique, comme le modèle d’IA plus avancé GPT-4, devront subir des évaluations approfondies et tout incident grave devra être signalé à la Commission européenne.

Bon à savoir

🧑🏻⚖️ Pour les Pratiques Interdites : Les amendes peuvent aller jusqu’à 35 millions d’euros ou 7% du chiffre d’affaires annuel mondial.

🧑🏻⚖️ Pour le Non-respect des Exigences de Données, de Gouvernance, et de Transparence : Les sanctions s’élèvent à 15 millions d’euros ou 3% du CA mondial.

🧑🏻⚖️ Pour la Fourniture d’Informations Incorrectes : Les amendes peuvent atteindre 7,5 millions d’euros ou 1% du CA mondial.

Ce que les entreprises doivent faire

✅ Recenser tous les use-cases de l’entreprise contenant de l’IA. Attention ! les systèmes ayant inclus récemment des fonctionnalités et si celle-ci sont utilisées, doivent être répertoriés.

✅ Conduire des audits d’impacts pour classifier les risques des IA selon l’échelle d’IA.

✅ A l’image du GDPR, prévoir de signaler auprès des clients et des employés quand l’IA est utilisée.

✅ Revoir les processus d’achats en incluant des clauses IA (procurement & legal) et mettre en place une gouvernance IA pour collecter et monitorer les use cases.

✅ Commencer à réfléchir à une stratégie IT de tests et déploiements des IA qui sont entraînés.

✅ S’assurer que les données critiques et plus largement que les données de l’entreprise sont managées, gouvernées et sécurisées pour une utilisation responsable des données.

La fin en quelques mots

Un vote clé par un comité du Parlement européen est prévu pour ce 13 février, suivie d’un vote du Parlement européen en entier, prévu au printemps 2024. L’acte devrait entrer en vigueur avant l’été 2024 et commencer à s’appliquer en 2026, bien que certaines parties de la législation prendront effet plus tôt.

La gestion des données vous intéresse et vous êtes un professionnel ? Renseignez-vous sur mon programme de formation DARE – Data Manager: une formation de 2 jours pour acquérir les fondamentaux de la gestion des données et construire la stratégie MDM associée 🔥.

Have fun!

Laura

0 commentaires