Salut l’équipe 👋,

Comme promis, nous démarrons 2024 avec une série d’articles sur l’IA générative. Ces articles sont coécrit avec Thomas, Data Scientist, qui a gentiment pris le temps de partager ses connaissances avec moi. 😊

Remontant aux premières explorations de la linguistique informatique dans les années 1950-1960, la technologie a parcouru un long chemin. L’arrivée du T9 dans les années 1990 a révolutionné la saisie de texte sur les téléphones mobiles, posant les bases de la prédiction de texte. Puis, au tournant du millénaire, Google Traduction a transformé notre manière de franchir les barrières linguistiques, en appliquant des algorithmes statistiques à la traduction de langues. Cependant, c’est avec l’avènement du Deep Learning dans les années 2010 que les LLMs ont vraiment pris leur envol.

Les LLMs, ou « Large Language Models », sont des systèmes d’intelligence artificielle (IA) avancés conçus pour comprendre, générer et interagir avec le texte en langue naturelle. Ils sont formés sur de vastes ensembles de données textuelles et peuvent effectuer une variété de tâches liées au langage, telles que la traduction, la rédaction de textes, la réponse à des questions et la synthèse d’informations.

Voici quelques exemples de LLMs connus:

- GPT (Generative Pre-trained Transformer) Développé par OpenAI, il excelle dans diverses tâches telles que la rédaction de texte, la traduction, et la réponse aux questions, grâce à son apprentissage sur d’énormes volumes de données textuelles.

- BERT (Bidirectional Encoder Representations from Transformers) Développé par Google, est utilisé pour améliorer la compréhension du langage naturel, en particulier pour les moteurs de recherche.

- LaMDA : Créé par Google également, utilisé pour alimenter le bot de conversation Bard, est connu pour ses compétences conversationnelles avancées

- RoBERTa: Développé par Meta, il est une version améliorée de BERT qui a été optimisée pour offrir de meilleures performances.

- Falcon : Développé par le Technology Innovation Institute, Falcon est un LLM open source qui s’est classé parmi les LLMs pré-entraînés les plus performants sur la plateforme Hugging Face.

On peut effectivement dire que ces dernières années ont été marquées par une sorte de « course à la technologie » entre les plus grandes entreprises de tech dans le domaine. Cette compétition a été particulièrement visible avec la montée en puissance de GPT-3.5 d’OpenAI, qui a connu un succès notable tant auprès des entreprises que du grand public (OpenAI revendique aujourd’hui 180 millions d’utilisateurs par mois).

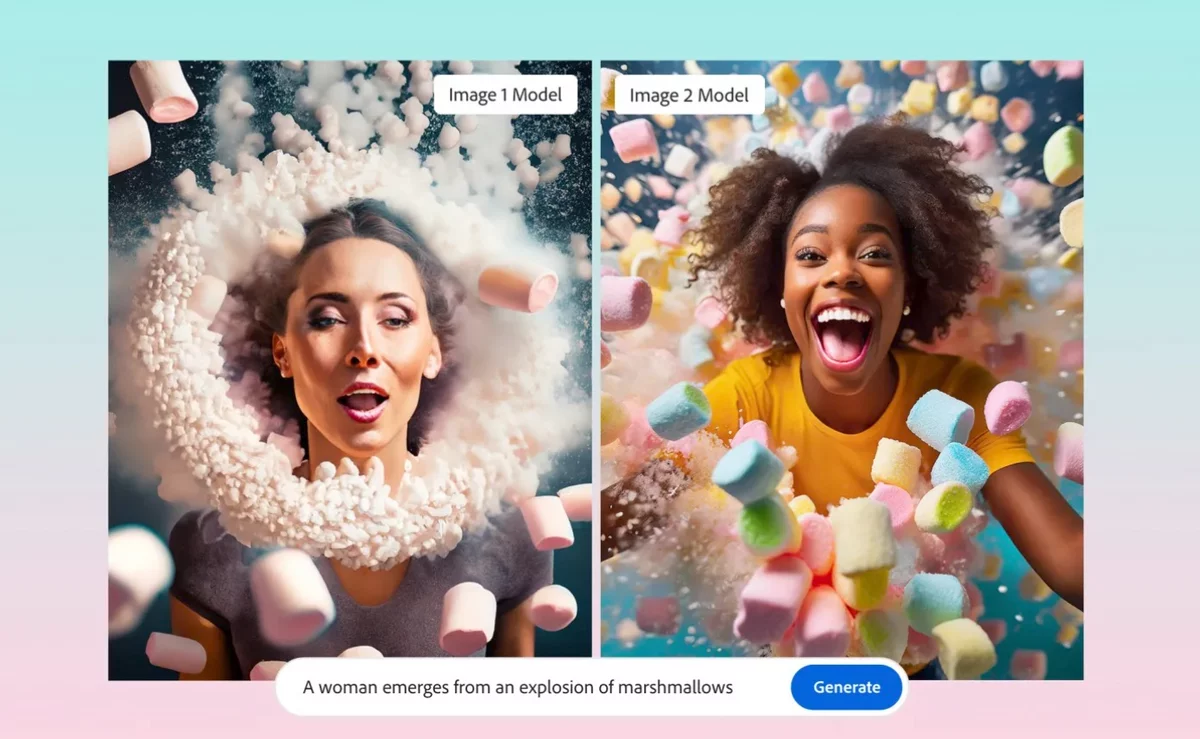

Les LLMs jouent un rôle essentiel dans les systèmes d’ IA générative. Par exemple des modèles de création d’images, comme DALL-E ou Midjourney, en ont besoin pour servir de intermédiaire, traduisant les descriptions textuelles des utilisateurs en instructions compréhensibles pour les algorithmes de génération d’images. Cette capacité rend l’IA génératrice d’images plus accessible et augmente la précision et la pertinence des images produites.

A quoi ça sert ?

On remarque une tendance à l’intégration de modèles de langage de grande envergure spécialisés dans des outils et plateformes spécifiques, comme le montrent les exemples de Microsoft Copilot et Google Bard ou encore des outils de génération d’images.

Voici quelques exemples en entreprise:

👉 Productivité des employés: Microsoft Copilot, est un outil de productivité, lancé en février 2023, qui intègre les LLMs avec les applications Microsoft 365, comme Word, Excel, et PowerPoint, pour améliorer la créativité, la productivité et les compétences des utilisateurs. Il ne s’agit pas d’un LLM indépendant, mais plutôt d’une plateforme qui l’utilise pour offrir des fonctionnalités intelligentes et contextuelles dans diverses applications Microsoft. Le test que j’ai réalisé qui m’a le plus marqué est la rédactions des comptes-rendus… Merci Copilot!

👉 Pour l’optimisation des processus internes, ils automatisent et rationalisent des tâches complexes, allant de la planification de réunions à la gestion de projets, en passant par la gestion de la documentation.

👉 Dans le domaine de l’analyse de données et de la génération de rapports, les LLMs peuvent traiter rapidement de grands ensembles de données pour en extraire des insights pertinents, générer des rapports automatisés et fournir des résumés détaillés, aidant ainsi les entreprises à prendre des décisions éclairées basées sur des données. On peut cité par exemple l**’outil Q&A de Power BI** qui permet de poser directement des questions sur notre base de données ou nos rapports.

👉 L’intégration avec d’autres technologies est un autre domaine clé où les LLMs montrent leurs valeurs. Ils peuvent se connecter et interagir avec divers systèmes d’entreprise, tels que les CRM et les ERP, pour améliorer la communication entre les différentes plateformes et optimiser les workflows. Par exemple Salesforce Einstein utilise l’IA pour analyser et prédire les tendances dans les données CRM et ERP, offrant des insights personnalisés et des recommandations pour améliorer les interactions client et optimiser les processus financier.

👉 En matière d’assistance juridique et de conformité, ils peuvent analyser et résumer les documents juridiques, aider à la rédaction de contrats et veiller à la conformité réglementaire, réduisant ainsi les risques juridiques (exemple: legartis.ai).

👉 Enfin, dans le secteur du marketing et des réseaux sociaux, les LLMs sont capables de générer des idées créatives pour les campagnes, d’analyser les tendances des réseaux sociaux, et de produire du contenu engageant. Nous pouvons citer les deux plus gros éditeurs : Adobe avec Firefly et Canva AI.

Gardons en tête que pour le moment, l’idée n’est pas de réduire le nombre d’employés mais plutôt de leur donner de nouveaux super-pouvoirs pour qu’ils puissent aller plus loin, sans se sentir limité par la technologie ou perdre des heures à rechercher une information.

Alors, comment ça fonctionne ?

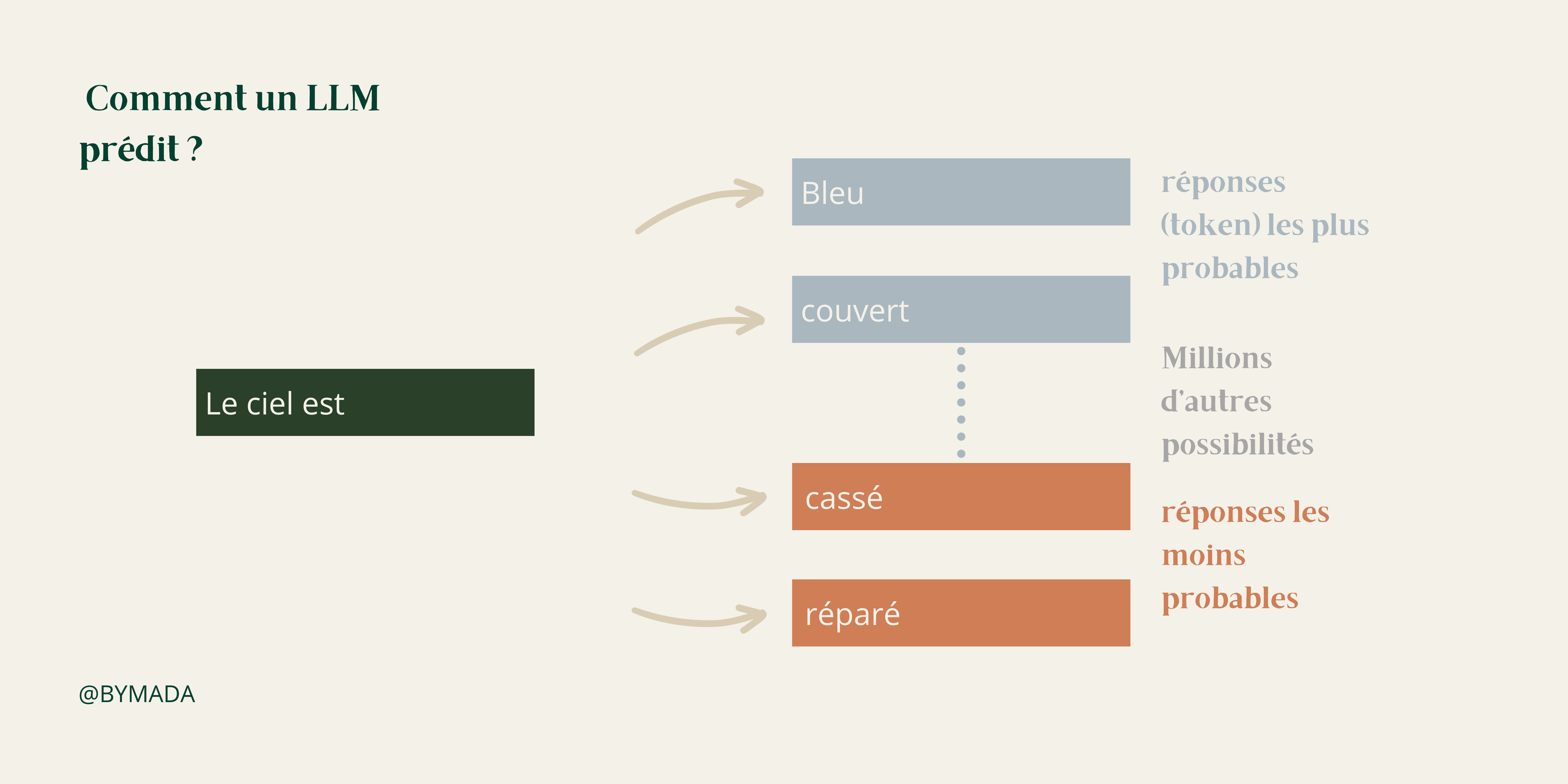

Imaginez un magicien qui, en lisant dans vos pensées, devine exactement ce que vous allez dire ensuite. C’est un peu ainsi que fonctionnent les Large Language Models ! Au cœur de ces modèles se trouve l’art de prédire le texte. Tout commence par la transformation des mots en chiffres, ou plus précisément en vecteurs. Cela aide les LLMs à comprendre non seulement la signification des mots mais aussi comment ils se relient les uns aux autres dans le grand puzzle du langage.

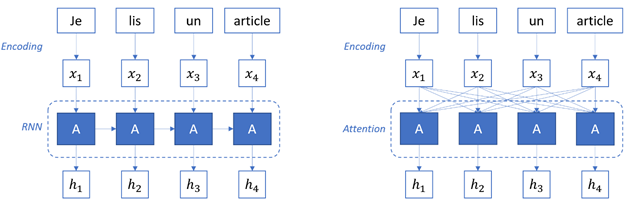

Concrètement un grand modèle de langage utilise un type spécial de Réseau neuronal , appelé l’Architecture Transformer, qui est composé de parties appelées encodeurs et décodeurs. Ces parties ont une fonctionnalité spéciale appelée « auto-attention », qui leur permet de traiter des morceaux de texte simultanément, plutôt qu’un à la fois. Cette méthode est plus avancée que les anciennes méthodes tel que le RNN, qui traitaient le texte séquentiellement.

Mais comment deviennent-ils si doués pour prédire ? En lisant !

Oui, en parcourant un nombre incroyable de textes, des livres aux articles en ligne. C’est cette vaste expérience de lecture qui les rend si habiles à comprendre et à générer du langage, comme un bibliophile qui a lu tous les livres de la bibliothèque. C’est la phase de pré-entraînement. Durant cette étape, le modèle est exposé à une quantité massive de données. Cette exposition lui permet d’apprendre les fonctions linguistiques de base et de se familiariser avec une vaste gamme de connaissances et de structures linguistiques. Le nombre élevé de paramètres utilisés par ces modèles, similaire aux souvenirs accumulés par la mémoire humaine durant l’apprentissage, enrichit leur banque de connaissances et améliore leurs performances.

Après le pré-entraînement, les LLMs subissent une phase de fine-tuning, où ils sont ajustés pour des tâches spécifiques. Ici, ils sont formés sur des ensembles de données plus ciblés, ce qui affûte leur capacité à répondre à des besoins spécifiques. Cette étape est comme un cours de spécialisation après un enseignement général. Ainsi, un LLM pré-entraîné peut être adapté pour des applications telles que la traduction, l’assistance juridique, ou même la composition poétique.

Quelles sont leurs limites ?

Il est néanmoins essentiel de garder à l’esprit les limites et défis des LLM :

🔍 Biais et Préjugés: Imaginez un LLM comme un miroir qui reflète les données avec lesquelles il a été formé. Si ces données contiennent des biais ou des préjugés, le LLM risque de les reproduire, menant parfois à des sorties fausses ou toxiques. L’exemple l’échec de Tay de Microsoft qui en 2016 à générer des propos remplis de préjugés au bout de quelques heures d’existence.

🧠 Problèmes de Contexte et de Mémoire: Chaque LLM a une limite de mémoire. Si vous lui donnez trop d’informations à traiter, il peut se « perdre » et ne plus être capable de réaliser correctement la tâche demandée.

🌍 Coûts et Impact Environnemental: Le développement et le fonctionnement des LLMs nécessitent des ressources énormes, tant en termes d’investissement financier qu’en consommation d’énergie (fonctionnement des serveurs).

🚨 Hallucinations et Sécurité: Parfois, un LLM peut créer des réponses complètement fausses ou inappropriées, on appelle cela des « hallucinations » (ex: citer un auteur qui n’existe pas). De plus, s’ils ne sont pas correctement surveillés, ils peuvent poser des risques de sécurité, comme la fuite d’informations personnelles ou la propagation de spams et d’escroqueries.

🤔 Consentement et Éthique: Les données utilisées pour entraîner peuvent parfois être collectées sans consentement, soulevant des questions éthiques et légales, notamment en matière de droit d’auteur et de confidentialité.

Concernant ce dernier point, l’année 2023 fut un vrai sujet de préoccupation au niveau des différents gouvernements, notamment en Europe. Le RGPD, entré en vigueur en 2018, axé sur la protection des données personnelles, impose des règles strictes sur la collecte, l’utilisation et la minimisation des données, surtout dans le contexte de l’intelligence artificielle. Il souligne l’importance de la transparence et de la protection des données, en particulier lorsqu’il s’agit de données sensibles.

Par ailleurs, l’UE AI Act pour lequel le Parlement européen a atteint un accord provisoire en décembre 2023, constitue une percée significative. Il établit un cadre réglementaire pour les systèmes d’intelligence artificielle au sein de l’Union Européenne. Ce cadre classe les systèmes d’IA selon leur niveau de risque et définit des exigences précises pour chaque catégorie. L’objectif de ce cadre est d’assurer que les systèmes d’IA déployés soient sûrs, transparents, traçables, éthiques, non discriminatoires et respectueux de l’environnement.

La fin en quelques mots

Ce n’est que le début de l’aventure, il y aura des erreurs et de nouvelles réglementation. C’est le moment idéal aujourd’hui pour les entreprises de réfléchir à leur posture face à l’IA en tant que marque et employeur: c’est à dire mettre en place un cadre pour des IA éthiques. La gouvernance de données devient aussi critique: si les données utilisées pour entraîner un modèle sont fausses ou biaisées, qu’est-ce qui garanti la véracité des réponses ? La mise en qualité des données et la gouvernance associée devient un must-have de toute entreprise voulant utiliser ces outils.

La gestion des données vous intéresse et vous êtes un professionnel ? Renseignez-vous sur mon programme de formation DARE – Data Manager: une formation de 2 jours pour acquérir les fondamentaux de la gestion des données et construire la stratégie MDM associée 🔥.

Have fun!

Laura

0 commentaires